人工智能推动光连接需求激增

随着全球数字经济的快速发展,云计算提高了人们对数据传输速度的期望,但人工智能(AI)工作负载给带宽以更快、更可靠地传输数据带来了更大的压力。

虽然像Compute Express Link(CXL)这样的协议有助于优化数据存储位置,使其更接近需要的位置,但连接对于尽可能快地移动数据仍然至关重要。在采用率下降之后,亚马逊和谷歌等公司在数据中心扩展人工智能的光收发器技术有所增加,而连接性则与硬件和软件一起融入到全栈系统中。

光通信市场研究公司LightCounting在其2023年7月的大型数据中心光学报告中表示,光收发器销量的增加与GPU和基于GPU的AI集群系统销量的大幅增长相关。该公司预测,未来五年用于人工智能集群应用的以太网光收发器销售额将达到176亿美元,而同期以太网收发器的所有其他应用合计将产生285亿美元的销售额。

支持人工智能集群的部署抵消了云计算公司因预计经济衰退尚未实现而削减的支出。

对人工智能连接的需求比最近炒作的ChatGTP早了几年,谷歌在2019年至2020年期间在其人工智能集群中部署的光学器件比其数据中心基础设施的其他部分还要多。据LightCounting估计,到2022年,部署在AI集群中的光收发器已占整个市场的25%。

LightCounting首席执行官Vlad Kozlov在接受采访时表示,在2022年底,生产需求有所放缓,这意味着今年第一季度光模块销售将出现下滑。但是,到今年4月,英伟达在人工智能领域的业务明显活跃起来,这也推高了LightCounting的预测。“这也提醒了所有正在建设人工智能基础设施的竞争对手。”

对人工智能更广泛的兴趣推动了简化基础设施部署的需求

Kozlov表示,英伟达在人工智能基础设施市场的关键优势在于,它开发了包括光连接、硬件和软件的全栈系统。“如果你看看谷歌和亚马逊正在做的事情,就会发现他们正在内部开发人工智能硬件和软件。”

他说,这些公司和微软等其他公司已经从人工智能应用中赚钱有一段时间了,但ChatGPT的出现,让人们认为人工智能可以在不同行业更广泛地使用,以提高工人的生产力。“除了非常大的公司之外,许多其他公司也开始关注人工智能。”

Kozlov表示,全栈解决方案很有吸引力,因为许多公司不具备构建软件和硬件的专业知识,因此转向Nvidia可以更轻松地开始构建人工智能基础设施。

在连接方面,光收发器的优势在于能够在更长的距离上支持更高的数据速率。虽然铜的弹性比预期更强,但距离随着数据速率的提高而缩短。“与此同时,人工智能集群正在变得越来越大。”Kozlov表示,谷歌正在讨论在其阵列中拥有数万个GPU。“当系统变得那么大时,显然距离也会变大。你需要使用更多的光学器件。”

Kozlov表示,除了能够长距离高速传输信号之外,光转换的吸引力还在于它们可以更轻松地重新配置连接——当GPU跨数据中心的不同部分时,灵活性非常有用,有助于提高可扩展性和可靠性,因为可以快速绕过有问题的节点以保持模型运行。

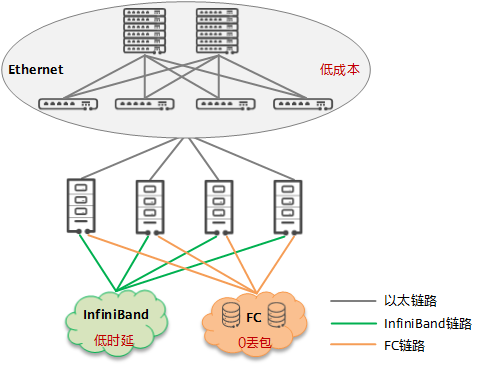

光收发器与协议无关,这意味着它们可以很好地与以太网和InfiniBand配合使用。也没有光纤连接器——全是电气的。

Kozlov表示,一个显着的趋势是从光缆转向可插拔光学器件。“它只是一个插入服务器的小型设备。”

他表示,英伟达是最新光学热潮的推动者之一,由于其解决方案的高连接密度,英伟达正在转向可插拔收发器。LightCounting报告称,英伟达2023年4月的财报电话会议暗示了人工智能基础设施的总体资金规模,尽管实际数字尚不清楚。Nvidia2023年第二季度的收入预计将环比增长50%,这主要是由用于AI集群的GPU和基于GPU的系统的销售推动的,这使得一些财务分析师估计未来五年用于AI的累积收发器收入将达到1000亿美元或更多单独的应用程序。

工作负载定义数据中心设计

Nvidia网络高级副总裁GiladShainer在接受媒体采访时表示,整个数据中心的设计需要有针对性,其中包括人工智能工作负载及其所需的连接。“一切都必须以平衡的方式进行。”

他说,人工智能工作负载分布在数据中心的不同连接设备之间。“定义数据中心功能的元素是网络。将所有内容连接在一起的方式决定了您将能够运行什么样的工作负载。”

Shainer表示,一旦这些元素就位,就可以创建进入数据中心的必要芯片和ASIC。

InfiniBand在Nvidia的AI数据中心解决方案中发挥着关键作用。该公司的Quantum InfiniBand网内计算平台专为高性能计算(HPC)、人工智能和超大规模云基础设施而设计。但Nvidia也有自己的NVLink,这是一种基于有线的串行多通道近距离通信链路。它使用专有的高速信号互连(NVHS),与PCIExpress不同,一个设备可以由多个NVLink组成,并且设备使用网状网络而不是中央集线器进行通信。

Shainer表示,NVLink的作用是共享内存访问,并与InfiniBand一起允许横向扩展整个平台。

他补充说,平台本身的目的很重要。“你想运行什么样的工作负载?你想解决什么样的问题?”Shainer表示,一旦确定了数据中心的用途,就可以在其中安装适当的网络,包括InfiniBand和NVLink,以获得必要的数据吞吐量,这是更困难的部分,同时还需要大量带宽快点。“你需要快速完成它的原因是因为你正在处理分布式计算。”

Shainer表示,重要的是网络在大规模满负载下的能力,最慢的链路决定了系统的整体性能。为传统云计算构建的数据中心并非旨在提供人工智能工作负载所需的性能,这可能需要数千个GPU以极低的延迟工作。“这是一个非常复杂的过程,你需要同步,”他说。

施耐德电气创新和数据中心副总裁SteveCarlini表示,人工智能工作负载已经彻底改变了IT和物理基础设施,而不仅仅是从网络角度来看。在接受媒体采访时,他表示,近年来,各种规模的公司都在疯狂争夺建设支持人工智能的基础设施。“它不再部署标准套接字X86服务器。”

Carlini表示,人工智能数据中心拥有CPU、GPU、加速器和DPU,需要一个架构来移入和移出数据。“每个GPU加速器都有一个网络端口,并且它们都同步运行。”

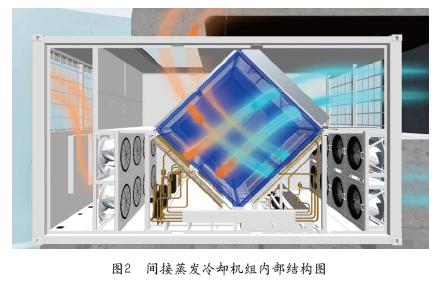

Carlini说,人工智能数据中心与传统数据中心的另一个显着区别是,它们一直在运行工作负载,这会改变设计参数。“这是令人难以置信的热量。”

Carlini表示,将10000个GPU集中在一起并将它们放入服务器机架中确实面临物理限制,其中最重要的是热量。除了各种冷却选项之外,解决方案是将所有部件分开。“实现这一目标的障碍在于网络。”他表示,尽管光收发器成本已大幅下降并且可以覆盖更远的距离,但运行400gig InfiniBand并不便宜。“最大的犹豫实际上是网络成本,因为每个GPU都有自己的网络连接。”

连接速度较慢也有其用武之地

并非所有连接都需要是像InfiniBand这样的快速光纤连接。Carlini表示,有一些基于铜缆的创新,例如Broadcom的Jericho3,它专为AI集群而设计,运行速度可达800GB。“这似乎是很多人都在等待的解决方案。”

Carlini表示,快速、可扩展的连接以及铜缆的可靠性和低成本是圣杯,但任何数据中心都将拥有包括光纤、铜缆和无线在内的解决方案层次结构。

Carlini表示,将要摄取的数据可以通过铜线传输到数据中心,而WiFi足以满足管理功能。他说,实时关键任务人工智能需要光学连接,特别是当模型开始摄取更多视频和图像而不仅仅是文本时。

Lightcounting的Koslov表示,光学连接的下一个前沿是可插拔的——它将与GPU和ASIC共同封装。“你不必担心插入收发器。电子芯片将会产生光学器件。”

他表示,光学的基本优势不会消失。“我们看不到任何替代方案。”

然而,Koslov表示,尽管存在局限性,但铜仍在继续寻找改进的方法。“光与铜将共存。”

本文标题:人工智能推动光连接需求激增

本文链接:https://www.blueocean-china.net/zhineng/870.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。