AI驱动的数据中心芯片设计创新及硅基光电子技术的应用

摘要 :大型语言模型等人工智能的快速崛起,为数据中心带来了对计算能力和效率提升的巨大需求。然而,这些人工智能模型的进化速度远超硬件的进步速度。本文回顾了人工智能对芯片设计领域产生的深刻影响,以及为填补日渐扩大的差距所需的架构创新。文章重点探讨了性能、功耗、散热、数据传输和灵活性方面的关键挑战。先进的封装技术、新型互连、软硬件协同设计以及早期优化在克服这些障碍方面至关重要。尽管面临艰难的权衡取舍,但创新性的解决方案有助于催生人工智能加速的新时代。

导言

近年来,人工智能呈现爆炸式增长,应用领域极为广泛。大型语言模型如ChatGPT的出现,令公众震惊。然而,对于人工智能计算力的不断增长的需求,也催生了对数据中心处理器进行优化的必要。算法的快速演变使得这成为了一个移动的目标。芯片架构师需构建具有灵活性的架构,以持续适应变化 [1]。软件的进步速度已经超过了摩尔定律所规定的硅材料性能的改进速度。这种情况迫使我们采用3D堆叠等创新封装技术,以提升计算密度,但同时也为整个设计流程带来了新的复杂性。

优化人工智能工作负载需在功耗、性能、面积和上市时间等多方面进行艰难的权衡。数据传输和散热已成为主要的瓶颈。本文概述了人工智能所引发的范式转变,以及在应对相关架构挑战方面的洞见。

人工智能巨大的计算需求

大型语言模型代表数据中心计算需求前所未有的转折点。硬件通常渐进改进,而人工智能训练工作负载数月翻一番。这给半导体技术进步带来巨大压力。人工智能算法需要极大的计算强度和内存容量。功耗也尤为关键,特别是训练工作负载。推理乍得询需要低延迟处理大量数据。人工智能芯片设计必须权衡这些极端、不断变化的需求。

对整个设计流程的连锁影响

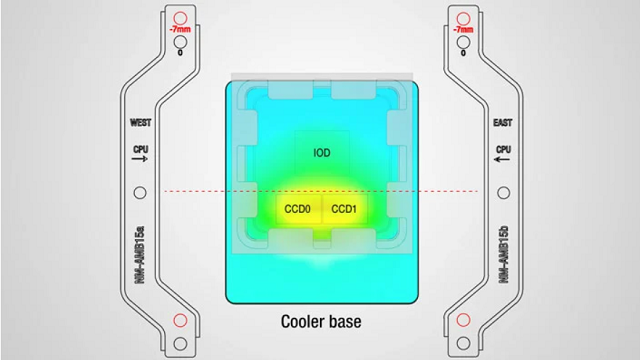

优化人工智能处理器对整个设计流程影响深远。必须提前用真实工作负载进行探索,以评估功耗与性能的权衡。热分析和功耗分析也需要前移。多芯片集成更加普遍,需要先进的封装专业知识。片上数据传输成为核心瓶颈。存在定制特定算法与容纳算法变化灵活性的张力。上市时间压力使问题更复杂 [2]。

架构选择

人工智能芯片设计有几个关键架构决策。计算引擎和内存类型选择会产生连锁影响。拆分为芯片组可以提升密度,但需要高带宽、低延迟的互连。数据传输需要光学输入/输出或硅基光电子技术。热设计需要智能传感器和限制。功耗预算决定高级睡眠方案。支持快速重配置和细粒度测试提供算法敏捷性。随着算法演变,灵活性很重要。

日益扩大的技术鸿沟

核心挑战在于人工智能模型的快速进步与硬件进步的相对缓慢之间的差距。尽管硅的尺度放缓,但芯片间通信仍遭遇瓶颈。人工智能的进化速度超过了多年的处理器设计周期。这需要新的架构、封装和软件集成以实现规模扩展,但更多的芯片组带来了功耗和数据堵塞问题。灵活性、模块化和协同设计对于赶上节奏很重要。

剩余需攻克的障碍

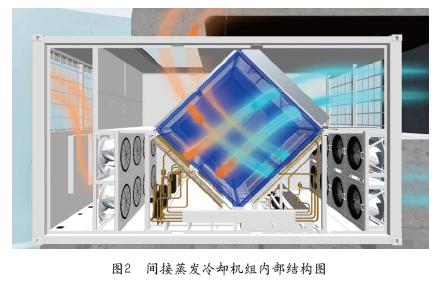

设计高性能、高效的人工智能芯片仍面临许多障碍。必须解决热量和功耗问题,可能需要新材料或复杂的传感器。片上数据传输的局限需求创新解决方案,如先进的互连或硅光子技术。设计流程前期的广泛软件探索对工具和方法提出了挑战。在专用硬件、芯片组和通用处理器之间划分工作负载仍具有难度。快速设计迭代和自动化在未来将变得很重要。

前进之路

为应对人工智能带来的范式转变,芯片架构师需要采纳新的架构、先进的封装技术以及更紧密的软硬件集成。能够跨越硬件和软件界限的公司将享有更强的竞争优势。模块化、灵活性和新方法将成为关键推动力。尽管权衡取舍依然困难重重,人工智能革命也带来了巨大的机遇,推动行业进入数据中心计算的新时代。借助创新思维,芯片设计师可以释放人工智能的无限潜力。

人工智能对数据中心芯片的挑战

人工智能正在数据中心市场上,技术进步与客户需求之间产生明显差距。ChatGPT 和 Dall-E等大型语言模型的出现,极大增加了对人工智能芯片进行更多数据处理、更低延迟、更高效率和更强功能性的需求。然而,人工智能模型的快速演变也需要内置灵活性,以适应算法的持续变化。 在严格功耗预算下,数据中心的人工智能处理器需要为推理乍得询提供高吞吐量。训练工作负载计算量更大,可消耗兆瓦级电力。片上数据传输和通信成为关键需优化的瓶颈。高密度的先进封装技术加剧了散热问题。人工智能芯片设计者必须在性能、功耗、成本、上市时间和算法灵活性等方面进行艰难平衡 [3]。

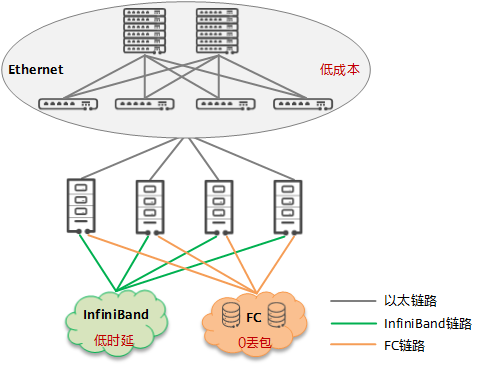

数据中心芯片对人工智能的解决方案

许多新颖的架构正在出现以满足数据中心人工智能的需求。对于推理应用,服务器CPU正在使用GPU、TPU和FPGA进行加速。新型存储技术如高带宽内存和计算快速链接提供更高带宽和新拓扑结构。先进的 2.5D 和 3D 封装技术集成更多计算芯片,使用硅中间芯片和硅通孔技术。这允许对不同功能进行芯片组划分和实现。光学输入/输出使用硅基光电子技术减少数据传输瓶颈 [4]。初创公司正在探索针对特定模型定制的崭新人工智能加速器架构。人工智能工作负载的激增正在推动新一波异构计算的专业化浪潮。

人工智能对数据中心芯片的权衡

优化人工智能芯片的性能、功耗和成本/面积需要进行艰难的权衡。更多片上内存可以提高数据本地性,减少外部带宽需求,但增加成本。更高内存带宽可提升性能,但会增加功耗和散热问题。低延迟互连如NVLink需要额外引脚和芯片面积。新型先进封装提高密度但也带来可靠性风险和良率损失。更专用的人工智能加速器减少顶层数据传输但限制灵活性。定制特定算法的硬件与支持更多算法敏捷性的可编程平台之间存在张力。人工智能芯片架构师必须在这些相互竞争的约束条件之间找到正确的平衡点。

硅基光电子的作用

硅基光电子作为潜在解决方案,以提高数据中心不同人工智能芯片之间的通信速度和效率。硅基光电子使用光而不是电信号来传输数据,这可以减少功耗和延迟。随着在人工智能设计中使用更多芯片组,产生了更多集成和组件间协调需求, 硅基光电子可以帮助缓解日益增加的数据传输和通信瓶颈,以提升系统性能 [5]。

未来挑战

未来人工智能芯片设计的一些关键挑战包括:

弥合人工智能算法和模型快速进步与硬件能力较慢提升之间的差距。

管理高密度先进封装技术所带来的热量和功耗需求。

在性能、功耗、成本、上市时间和灵活性方面找到平衡。

克服片上和片间的数据传输和通信瓶颈。

开发新型互连、芯片组和硅基光电子等技术以提速和效率。

在设计流程早期就进行广泛的软件探索和功耗分析。

实现足够的模块化和灵活性以适应人工智能模型的持续演变。

在专用硬件、芯片组和通用处理器之间进行最佳工作负载划分。

整合注重人工智能的方法、工具和流程以自动化和加速设计过程。

推动系统架构师、硬件设计师和软件开发者之间更紧密的协作。

探索针对特定模型或应用程序的全新人工智能优化架构。

结论

人工智能代表了芯片设计颠覆性的转变。应对这一挑战需要架构、先进封装、设计方法、软件集成以及工具等方面的改变。掌握人工智能巨大计算需求的公司在竞争中将处于优势。但这需要软硬件界走得更近。前方存在艰难权衡,但人工智能也推动计算步入新时代,带来巨大机遇。通过创新思维和团结协作,整个行业可以释放人工智能的全部潜力。

本文标题:AI驱动的数据中心芯片设计创新及硅基光电子技术的应用

本文链接:https://www.blueocean-china.net/faq3/944.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。