AI技术在数据中心领域能耗优化方面的应用

在能耗管理方面,人工智能技术已在数据中心能耗分析和预测领域取得进展。通过收集历史能耗数据、机房温湿度和气象数据等多种因素,构建预测模型。利用预测模型对未来能耗进行预测,并依据预测结果对能耗进行调整与优化,实现有效的能耗管理,从而降低能耗并提高整体效率。

尽管目前这些模型在应对数据种类缺失、缺乏丰富算法模型和算法组合灵活性不足,人工智能技术在数据中心能耗管理及优化方面仍开始逐步发挥着关键作用。

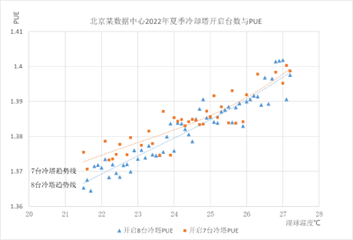

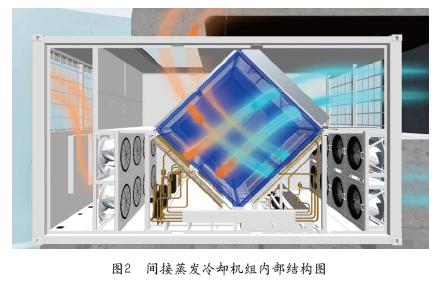

以利用机器学习技术优化数据中心能耗管理为例。在数据中心能耗管理的场景中,可以将历史能耗数据、天气数据以及其他可能影响能耗的因素作为输入,来训练一个机器学习模型。这个模型可能使用监督学习的方式,即根据已知的输入 (比如气温、湿度、负载量等) 和输出(实际能耗 ) 进行学习。训练完成后,模型将能根据输入的天气数据和预期负载量等信息,预测未来某一时间点的数据中心能耗。依据这一预测结果,数据中心可以更加精确地调整其能源策略,例如优化设备的运行状态、调度任务的执行顺序,甚至调整冷却系统的运行方式,从而实现更高效的能源管理。因此,机器学习在数据中心能源管理和资源调度中提供了强大的支持。

Google 利用其 TensorFlow 机器学习框架,通过分析数据中心的负载模式和服务器资源利用率,对任务的分配和调度策略进行自动调整,从而优化了能源管理并实现了能源利用的最大化,通过使用机器学习技术,Google 成功地将其数据中心的冷却能耗降低了40%。但这种方法在冷冻水系统的应用中经常要进行针对性的调整,需要专业的人员参与和现场调试,这是对新技术普适性应用的常见挑战。在算力需求方面,系统可能需要一些特定的场景才能发挥最大效能,但随着硬件技术的不断进步,这也让我们看到了 AI 技术在不断适应和学习的过程中,其潜力和灵活性不断提高

本文标题:AI技术在数据中心领域能耗优化方面的应用

本文链接:https://www.blueocean-china.net/faq3/929.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。