警惕!ChatGPT爆火下的能耗危机,数据中心运营商挑战巨大

即使是数字产品也需要能源来开发和消耗,ChatGPT也不例外,据估计,机器学习工作中推理处理占算力消耗的80-90%,粗略计算,自ChatGPT于2022年11月30日上线以来,碳排放已超过814.61吨。

——摘要

近期,美国OpenAI公司旗下智能聊天工具ChatGPT刷爆社交媒体,吸引超百亿美元投资,推动了资本市场布局人工智能应用的巨大热潮,风头一时无两。

微软率先宣布砸100亿美金入股OpenAI,然后亚马逊和美版“今日头条”BuzzFeed宣布将在日常工作中启用ChatGPT,同时,百度也宣布于3月推出“中国版”的ChatGPT聊天机器人。在多家科技公司推波助澜后,ChatGPT瞬间引发全球关注。

数据显示,亚马逊部署的机器人数量正在快速增加,每天增量达到1000个左右。此外,脸书母公司Meta也计划2023年在数据中心上额外投入40亿至50亿美元,预计将全部用于人工智能。IBM首席执行官克里希纳表示,人工智能预料到2030年将为全球经济贡献16万亿美元。

随着ChatGPT的大火,2023年各巨头或将在人工智能领域掀起新一轮鏖战。

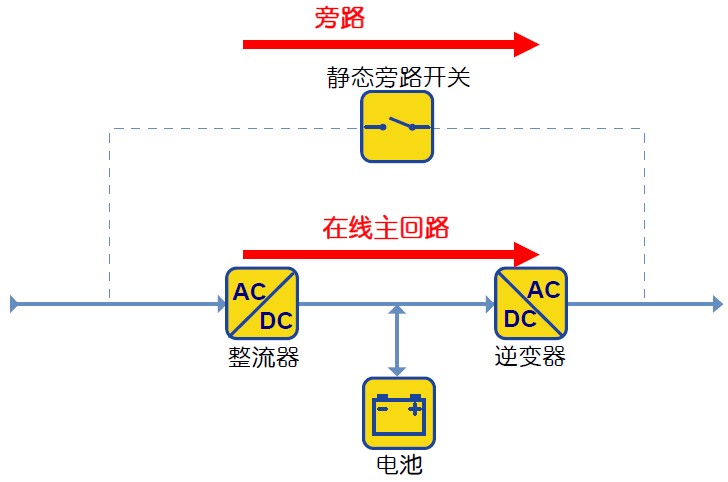

然而,当ChatGPT-3预测出现下一个的单词时,就需要进行多次推断计算,因此占用大量的资源,并耗费更多的电力。而为支持云计算、视频流媒体和5G网络的爆炸式增长而扩建的数据中心基础设施,其GPU和CPU架构不能有效地运行以满足迫在眉睫的计算需求,这为超大规模数据中心运营商带来巨大的挑战。

GPT3.5 的训练使用了微软专门建设的AI计算系统,由1万个 V100 GPU 组成的高性能网络集群,总算力消耗约 3640 PF-days (即假如每秒计算一千万亿次,需要计算3640 天)。如此大规模、长时间的 GPU 集群训练任务,对网络互联底座的性能、可靠性、成本等各方面都提出极致要求。

例如,Meta宣布暂停在全球范围内的数据中心扩建,重新配置这些服务器群,以满足人工智能的数据处理需求。

人工智能平台对数据处理的需求是巨大的,ChatGPT的OpenAI创建者在去年11月推出该平台,如果不搭上微软即将升级的Azure云平台的便车,它将无法继续运行。

支持这一数字转型的数据中心基础设施——将像人脑一样被组织成两个半球或叶,一个叶需要比另一个叶强得多。一个半球将服务于所谓的“训练”,处理多达300B个数据点所需的计算能力,以创建ChatGPT生成的单词沙拉。

训练瓣需要强大的计算能力和最先进的GPU半导体,但在支持云计算服务和5G网络的数据中心集群中,目前所需要的连接性很少。

同时,专注于“培训”每个人工智能平台的基础设施将对电力产生巨大的需求,要求将数据中心设置在千兆瓦可再生能源附近,安装新的液体冷却系统,以及重新设计的备用电源和发电机系统,以及其他新的设计特点。

人工智能平台大脑的另一个半球,被称为“推理”模式的更高功能的数字基础设施支持交互式“生成”平台,这些平台在输入问题或指令后的几秒钟内,对查询进行处理,进入建模的数据库,并以令人信服的人类语法作出响应。

虽然如今的超连接数据中心网络,如北美最大的数据中心集群,北弗吉尼亚州的“数据中心”也拥有最广泛的光纤网络,可以适应人工智能大脑“推断”叶的下一级连接需求,但这些设施也需要升级,以满足所需的巨大处理能力,并且它们需要更靠近变电站。

此外,有调研机构数据显示,数据中心已然成为全球最大的能源消费者,占总用电量的比例将从2017年的3%上升到2025年的4.5%。以中国为例,2030年全国运营的数据中心用电量预计将超过4000亿度,占全国总用电量的4%。

因此,即使是数字产品也需要能源来开发和消耗,ChatGPT也不例外,据估计,机器学习工作中推理处理占算力消耗的80-90%,粗略计算,自ChatGPT于2022年11月30日上线以来,碳排放已超过814.61吨。

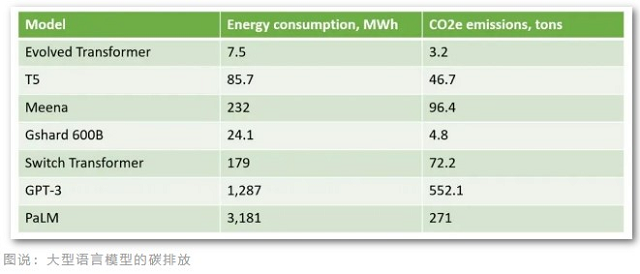

据专业机构测算,假设托管在微软的Azure云上的ChatGPT每天有100万用户咨询(在特定的响应时间和词汇量下,每天约29,167小时),按A100 GPU的最高功率407W(瓦特)计算,每天碳排放达到3.82吨,每月排碳超过100吨。如今ChatGPT日访问用户超过1000万,实际排碳量要远超每月100吨。除此之外,训练这样一个包含1750 亿参数的语言大模型,需要上万个 CPU/GPU 24 小时不间输入数据,大概消耗1287MWh的电力,二氧化碳排放量超过552吨。

从这些大型语言模型的碳排放来看,ChatGPT前身GPT-3碳排放最大。据悉,美国人平均每年产生16.4吨碳排放,丹麦人平均每年产生11吨碳排放。因此,ChatGPT的模型训练碳排放多于50个丹麦人每年的碳排放。

云计算供应商们也认识到数据中心使用了大量电力,并采取了提高效率的方法措施,例如在北极建设和运营数据中心,以利用可再生能源和自然冷却条件。不过,这还不足以满足AI应用爆炸式增长的需求。

美国劳伦斯伯克利国家实验室在研究中发现,在过去20年,数据中心效率的提高一直在控制能耗的增长,但研究表明,现在的能效措施可能不足以满足未来数据中心的需求。

人工智能产业现在正处于一个关键的转折点。生成式AI、图像识别和数据分析的技术进步揭示了机器学习独特的联系和用途,但首先需要建立一个能够满足这一需求的技术解决方案,因为根据Gartner的预测,除非目前能提供更可持续的选择,否则到2025年,AI消耗的能源将超过人类活动所消耗的能源。

来源:网络

本文标题:警惕!ChatGPT爆火下的能耗危机,数据中心运营商挑战巨大

本文链接:https://www.blueocean-china.net/faq3/342.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。