数据中心采用液冷技术的五大原因

概述

IT设备芯片功率密度是推动采用液冷技术的一个常见因素。但是,数据中心业主在决定采用液冷时还有另外四个原因,包括低电源利用率(PUE)目标、空间限制、严苛的IT环境和用水限制。本文对这些推动因素进行了介绍。借助这些信息,数据中心业主可以权衡采用液冷对他们设施是否有利,并做出明智的决策。

与传统风冷相比,液冷可为数据中心业主带来多项益处,例如能效更高、占用空间更小、总拥有成本(TCO)更低、服务器可靠性提升、噪声更低等。但是,液冷还存在一些缺点,例如投资更高、需要改造甚至重新订购服务器、需要新的数据中心运维技能等。

如需了解有关此话题的更多信息,请阅读《适用于数据中心和边缘应用的液冷技术》。数据中心业主需要确定液冷是否适合用于应对他们所面临的挑战。

在本文中,我们将介绍考虑采用液冷技术的五个原因:

不断增加的芯片和机柜功率密度

降低能耗的压力

空间限制

用水限制

恶劣的IT环境

本文详细阐述了每种原因,并解释了液冷技术是如何应对这些挑战。

1.不断增加的芯片和机柜功率密度

IT设备技术的变化一直是基础设施制冷解决方案研发的主要驱动力。如今,对云、物联网、人工智能和边缘应用的需求再次引发IT技术的变化,进而影响用于辅助的制冷基础设施。我们总结的部分此类变化如下:

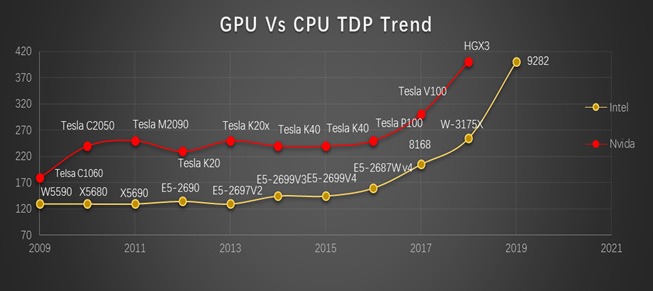

中央处理器(CPU)功耗增加。随着内核数量的增加,处理器性能不断提高,同时处理器功率也不断增加。这会导致CPU热流密度相应增加,以及服务器机柜本身内部的总体热密度增加。同时,某些场合下还会使用超频以提升运算性能(例如游戏和高性能运算),也会导致芯片温度升高(如图1所示)。

大功率图形处理器(GPU)的使用日益增加。GPU起源于3D游戏的渲染需求,如今广泛用于金融、分析、人工智能、科研和石油天然气勘探等领域,配合CPU分担运算负载。CPU的内核相对较少,但拥有大量的高速缓存,可同时处理多个线程。GPU由数百个内核组成,可同时处理数千个线程,相应地功耗更高(如图1所示)。

低延迟需求导致热密度增加。随着组件性能的提高,这些组件之间的互连在延迟方面开始成为瓶颈。为了充分利用性能方面的提升,CPU、GPU和板卡上的其他组件(例如内存芯片组)被安排得越来越紧凑,以减少延迟。这也导致服务器内部的物理密度和温度越来越高。

▲图1热设计功耗(TDP)呈上升趋势

所有这些IT技术趋势,都推动着服务器功耗和热密度的上升。当机柜中装有大量此类服务器时,由于机柜内的功率密度太高,风冷已经不足以使设备充分冷却。存在一些极端的风冷例子,例如采用主动式通风地板的房间级制冷系统,可支持40kW机柜的制冷,或者主动式背板换热器。采用行级制冷装置,可为最高67kW的超级计算机HPC设备提供制冷。然而,对多个高密度机柜使用这些极端应用时,制冷系统的总拥有成本(TCO)也会大幅增加。这些应用还会引发其他问题,例如过高的气流速度、巨大的风扇噪音,以及由于制冷中断而造成设备损坏的风险。

绿色网格(TGG)建议将每机柜15-25kW的功率密度作为“未使用背板换热器等其他制冷设备”的风冷解决方案的上限。相比之下,液冷系统很容易提供两倍于风冷方案的容量,甚至可以扩展到单机架超过100kW。液冷技术提供更具可预测性的热控制,且没有风冷所需的过度配置和风量管理。液冷技术还可提供更低的稳定工作温度,并消除湿度问题,以此提高芯片和硬盘驱动器的可靠性。

2.降低能耗的压力

随着人们建造越来越多的数据中心(包括云端、区域性和边缘数据中心),这个行业的能耗也在不断增加,2017年约占全球总能耗的1%。较高的能耗促使法规要求数据中心的电源利用率(PUE)需低于特定值,以降低能耗。例如,上海要求新建数据中心的PUE低于1.3,而改造现有的数据中心PUE低于1.4。数据中心的能源支出在总拥有成本(TCO)中所占的越来越大。继IT设备之后,制冷系统是数据中心的第二大能源消耗体。因此,数据中心业主急需减少制冷系统的能耗。

需要特别注意的是,我们通常使用PUE作为评估数据中心效率水平的指标,但是,对于采用液冷技术的数据中心,我们认为能耗是更适合的指标。使用液冷技术时,可以去除部分甚至全部的IT设备风扇,这可能导致PUE不如人意,但总能耗减少。对于浸没式液冷,去除服务器风扇可以将服务器能耗降低大约4%-15%,具体取决于所需的风量(通常分析中采用8%)。对于新建或改造的场合,可以通过使用液冷系统替代高能耗的风冷系统来降低能耗。由美国不同的国家实验室和英特尔组成的工作组总结出一个新指标,可让人们更清楚地了解此问题,并创建了iTUE(IT能源使用效率)和TUE(总能源使用效率)。截至撰写本文之时,尽管这些指标的使用有限,但随着液冷技术采用率的提高而将受到更多关注。

3.空间限制

虽然风冷系统可以处理相对密集的IT负载(例如,能够支持每机架超过67kW功率的部署方式也确实存在),但这样做的成本和复杂性随着IT负载的增加而激增。尽管随着密度的增加能够减少机柜的数量,但专用于制冷设备的物理空间比例却越来越高。哪怕是不占用地面空间(位于机柜顶部)的顶置式制冷设备也并不能解决问题,因为它们的制冷能力通常不超过20kW/机柜。

对于给定的IT负载,液冷技术可提供减少整体数据中心空间的机会。不仅白区可以得到压缩,由于可使用温水进行冷却,可以缩减制冷系统和相应的开关设备,进而也能压

4.用水限制

冷却塔和其他蒸发式制冷技术因其效率高和制冷量大,成为超大型数据中心受欢迎的散热解决方案。但是,这些方法将水的蒸发用作散热机理,会消耗大量的水(如图2所示)。用水会增加运营成本,而在水资源有限的某些地区,AHJ(主管机构)会向数据中心业主施加更大的压力,促使他们减少用水。

▲图2冷却塔利用水的蒸发来散热

减少数据中心用水的方法有多种,包括减少IT负载、提高制冷系统效率、优化冷却塔运行等。在这些方法中,液冷技术可以减少或消除制冷系统设计中的用水环节。由于大多数液冷技术都可以直接将温水用于IT设备(最高45°C/113°F),因此在大多数气候下可以使用简单的干冷器来散热。

5.恶劣的IT环境

随着网络边缘部署的IT设备越来越多,将其置于非理想环境中的需求也不断增加。在制造行业和配送中心的物联网等场合可能会带来新的挑战。在大气污染和电源质量方面,这些场合的环境条件非常恶劣(图3为两个示例)。这些场景中部署的通常是具有成本效益的标准IT系统,有时会导致可靠性低于预期。随着IT设备与生产流程的整合度越来越高,任何宕机都会影响制造工厂自身的产量。

石油天然气设施

汽车制造厂

图3恶劣IT环境的两个示例

集成空调的封闭机柜是一种解决方案,但可能占地空间大,成本高且效率低。在这些环境中,液冷技术可作为一种替代方案。浸没式液冷可将服务器与环境隔离。从IT设备中去除风扇可减少恶劣环境(例如重型工业制造工厂)中的大气污染物进入IT系统。

数据中心采用液冷技术的优势:

尽管前文提到的五个原因推动了液冷技术的普及,但是液冷技术的以下优势同样值得关注:

1.最小化房间内增加的热量

芯片级液冷可以将IT空间中70-80%的IT设备热量转移到室外环境,而浸没式液冷可以带走95%以上的热量。因此,IT设备所产生的热量对房间的影响可以大幅降低,从而让IT空间可以更轻松地实现舒适的工作环境。相反,对于采用传统风冷技术的数据中心,为了提高能效,从而提高IT设备的入口和出口温度,这可能导致在热通道中长时间工作的人员遭受热压力。欲了解有关此话题的更多信息,请阅读《高密度热通道对IT人员工作环境的影响》。液冷技术可以实现密度的增加并同时有效地保证舒适的工作环境。

2.消除风扇的使用

如上所述,去除风扇不仅可节省4%-15%的能耗,而且消除由风扇噪音引起的职业健康风险。对于传统的风冷系统,随着机柜密度的增加,随之而来的设施风扇噪音的增加不仅会影响操作人员和维护人员(可能会违反OSHA法规或ISO7243准则),而且还会增加IT磁盘驱动器故障风险。目前,许多服务器设计人员发现,风扇噪音的设计已经非常接近与服务器相关的人员职业健康能够承受的最大极限。由于制冷设备风扇产生的噪音,数据中心运营人员将面临同样的健康问题。

对于液冷技术,去除或减少服务器风扇以及消除或减少IT设备空间制冷(例如CRAH单元或CRAC单元)可提供非常低的噪声。这在军事和商业办公室应用中特别有用,可防止风扇噪音对职业健康造成危害。

3.余热回收

芯片级液冷或浸没式液冷中的绝缘介质回路可以使用温水(30°C/86°F以上)来吸收设备产生的热量。吸收了热量的热水可以非常有效地进行热回收再利用。回收的热量可用于设施或区域供热,以减少运营支出和设施的总体碳足迹,尤其是在寒冷的天气中。用风冷技术则很难做到这一点,这也是市政部门所青睐的原因。

4.降低布局复杂度(冷热通道和通道封闭)

对于采用风冷的数据中心,气流管理的最佳实践是将机柜按照冷热通道进行布局。然后,采用气流遏制系统对冷热通道进行遏制,以分离冷气流和热气流,进而节省制冷能耗并消除热点。对于采用浸没式液冷的数据中心,无需使用服务器和CRAH/CRAC风扇,因此无需担心气流管理,也无需留出冷热通道布局和进行气流遏制。机柜布局得以简化,并且仅取决于管道路径和可维护性,从而实现当前无法想象的布局。

5.减少对地理气候的依赖

用于为IT设备冷却的风冷自然冷却解决方案依赖于特定的地理位置。由于液冷技术可使用温度高达45°C/113°F的温水,因此在世界大部分地区都可以实现全部自然冷却。这为区域数据中心和边缘部署提供了标准化和高效优势。

液冷技术通常被视为高性能计算和高密度应用的技术解决方案。然而,液冷技术在大型数据中心和边缘部署也同样具有优势,它能有助于解决数据中心设计人员和运营人员当前所面临的诸多挑战。在所有地理区域均能实现降低能耗、减少用水量、能够部署在有限的空间以及恶劣的环境中,这是我们期望在未来几年内IT行业广泛采用液冷技术的几大原因。

本文标题:数据中心采用液冷技术的五大原因

本文链接:https://www.blueocean-china.net/faq3/241.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。