浅谈数据中心空调系统节能的若干问题

摘要

当今节能降耗成为数据中心建设和运行关注的焦点,特别是在空调系统建设中各种节能技术和设备开始普遍应用,但是在一些项目的建设和运行中节能效果不理想,投资回收期长,运行和维护成本的增加等等。针对这些问题,本文列举了当今数据中心空调系统在设计、建设和运维中需要关注的问题,希望对数据中心的设计、建设和运维有所帮助,同时望行内专家和高手斧正。

问题的提出

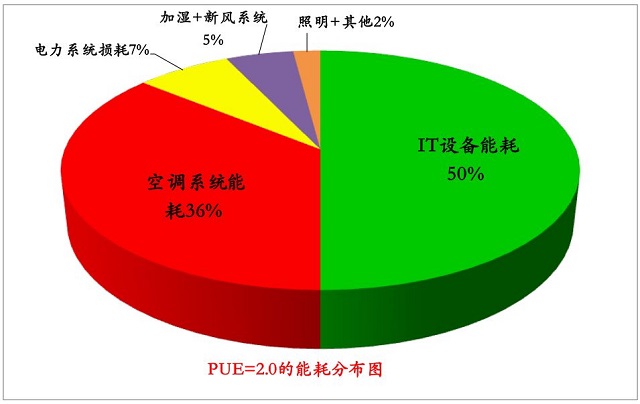

二十一世纪是信息化的时代,各种信息离不开计算机的处理,随着大数据与云计算的蓬勃发展,数据中心越建越多,规模越建越大。对一个1000个机架的数据中心来说,按照每个机架平均3kW计算,1000个机架负荷为3000kW,每个小时耗电3000kWh,全年电力耗能为:3000kWh *24h/d*365d =26280000kWh,按照1元/kWh计算,全年的电费2628万元,加上数据中心的空调、新风、照明、其他电力设备能耗,对一个PUE为2的数据中心而言,电费为5256万元,因此节能降耗成为数据中心建设和运维关注的焦点。PUE为2的能耗分布见图1。

图1 PUE=2的能耗分布图

当前提到PUE,必然与数据中心基础设施的能耗联系在一起,对于一个PUE为2.0的数据中心,在基础设施中空调的耗能占到36%,因此空调设备的制造商想尽办法研究如何提高空调设备的能效,然而在现实的数据中心的建设中会遇到以下的问题:制造商推荐了高能效和节能产品,设计院为了提高PUE,实施各种节能产品的组合,但是在一些项目中未能达到实际的效果。这里要说明的并不是说技术和产品本身性能不好,而问题在于不同的环境、不同规模的数据中心是否选择有针对性技术、产品或组合的方案。下面从六个大的方面谈谈数据中心空调系统建设和运维中需要关注的那些事,同时探讨数据中心建设、运维与节能平衡。

一、谈谈数据中心空调系统设备的能效

1、谈谈数据中心空调系统的综合能效

目前数据中心常见的空调设备有3种

目前在数据中心的建设中,有一种声音就是水冷比风冷节能,从设计方、产品厂商和许多的论坛的推介会,都在宣传水冷能效的优点。因此很多的建设方,不论规模多大都要求上水冷空调系统,到底风冷好还是说冷好,下面给出两个厂家的不同技术空调机组(裸机)的能效(见表1)。

表1 4种空调机裸机的设计能效

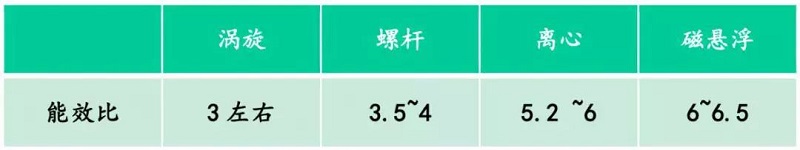

单从设备的自身的性能,可以看出的确水冷比风冷能效要高。对同等功率的空调机组,各家的产品的能效上有细微的差别,基本上上述空调的能效的范围见表2。

表2 4种空调裸机的能效范围

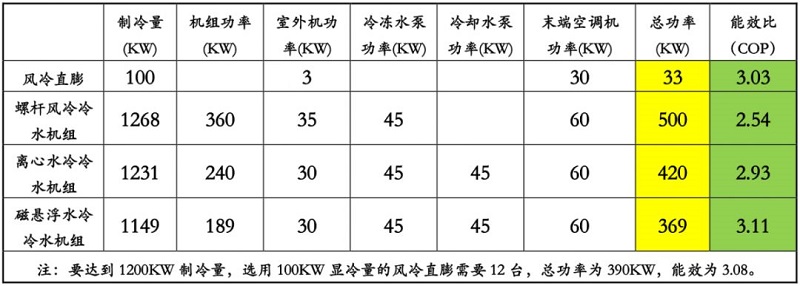

然而在一个空调系统中,不能单看空调主机的能效,除了制冷主机外还要有风机、水泵、冷却塔等有源的辅助设备,主机加辅助设备组成一个完整系统,下面给出上述四种空调机组系统的能效情况(见表3)。

表3 4种技术空调机组的系统能效

从对比数据可以看出,在同样的制冷量情况下,主机加上必须配套的设备,不同技术的空调系统的能效都是差不多的,能效在3左右。

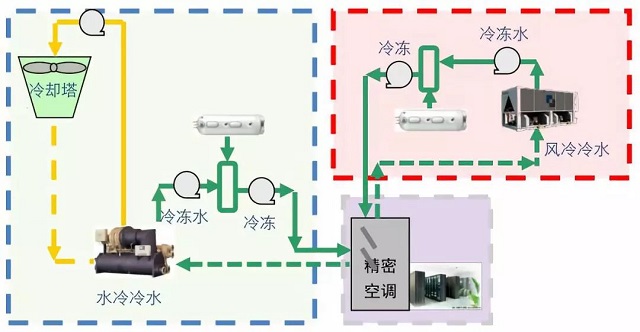

还必须看到风冷(或水冷)冷水空调系统还需要有分水器、阀门、管道等装置(见图2),有些还需要增加蓄冷罐、板换的装置,虽然这些装置是无源的,但水在板换、管道、阀门、蓄冷罐等设施中传输和交换会损失一部分的能量,经过的环节越多、管道越长带来损耗越大,因此加上这部分的损耗,进一步降低了空调系统的能效。

图2 水冷系统管道和室外冷塔

因此:空调系统的能效不能单看主机的能效,应该看整个系统的能效,在一个系统中增加的辅助设备越多,对能耗的影响越大。目前主流的各种空调设备,通过电控+冷媒的机械制冷从系统的角度能效比是差不多的。

目前如何进一步的提高空调系统的能效,必须是通过增加自然冷源的部件,利用外部大自然冷源,当自然环境满足要求时,使得空调系统进入半工工作状态或全自然冷却状态,通过减少空调制冷的用电来提高节能目的。

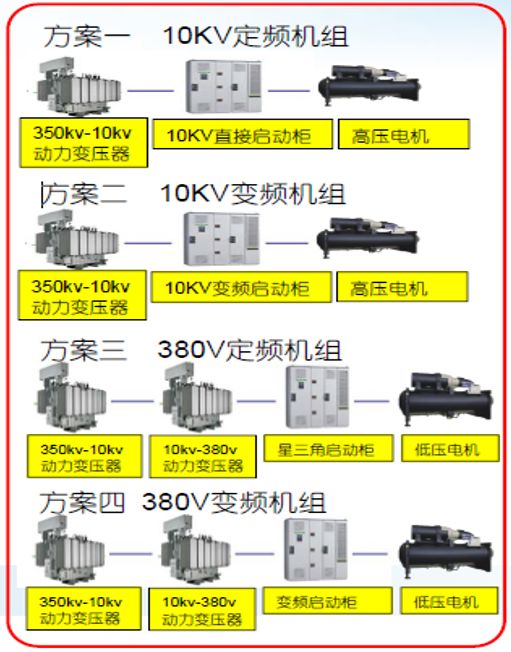

2、高压/低压冷水机组以及相配套辅助设备的性能比较

目前大型的数据中心均采用了离心水冷的空调系统,离心水冷机组有高压机和低压机以及定频和变频的产品,当今的设计中选用的低压变频的机组居多,配套的附加设备在一定程度上影响到离心水冷机组的能效。在这些产品中那种机型更好更节能,以高压/低压离心冷水机组为例,给出4种配置方案(见图3),分析和比较其能耗的情况。

图3 离心机组4种组合方案

高压机的起动和运行的电流低,电缆缆线径小损耗低;低压机启动和工作电流大,电缆线径粗;低压机需要增加一组变压器,增加了变压器损耗;低压机组采用变频的方案会产生30%左右的谐波干扰。4种方案的比较见表4,标注红色为方案的优势项。

表4 离心冷水机组4种组合方案的比较

以低压离心机组为例,增加的变压器在实施电压和功率的转换中会产生一定损耗,这部分损耗主要来自于变压器的铁损和铜损,这两个损耗反映在空载和带载两个方面。以1600kVA的变压器为例,厂家给出的空载损耗为2760W,带载损耗为12420W,变压器的年损耗=(2760+12420) *24h/d*365d =132977kWh,按1元/kWh计算每年变压器的耗能为132977元。

因此: 高压冷水机组省去了变压器,电流小、线损小,比低压冷水机组节能。高压冷水机组投资高于低压机组,但省去变压器的投资,与低压冷水机组的投资相当。 需要考虑高压冷水机组零部件的价格要比低压冷水机组高。

规范要求:《民用建筑供暖通风与空气调节设计规范》GB 50736-2012中第8.2.4.3款规定:当单台冷水机组电动机的额定输入功率在:

650kW ~900kW 时,可采用高压供电方式。

900W ~1200kW时,宜采用高压供电方式。

1200KW时,应高压供电方式。

3、需要关注变频技术的负面影响

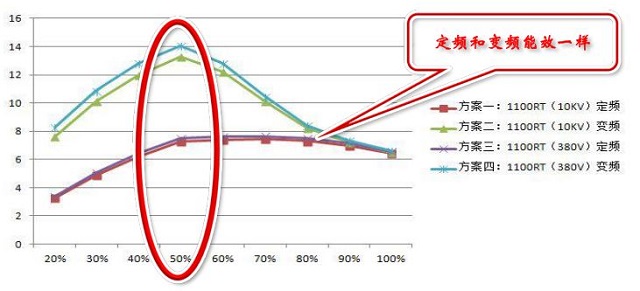

在空调系统的设计和现实的许多案例中,为了有效的提高设备的能效,采用变频技术,按照实际的负荷有效控制冷水机组、水泵和风机的转速,达到节能的目的。还以上述案例做相应的比较,在20~100%负载的情况下,各负载段的能效比见图4。

图4 定频与变频离心冷水机组不同负载情况下的能效情况

变频离心水冷机组的最高能效比是工作在50%负载的时候,其IPLV超过10,当负载超过80%时,定频和变频的能效趋于一致,在100%时变频的耗能要比定频高,因为增加了变频器耗能。

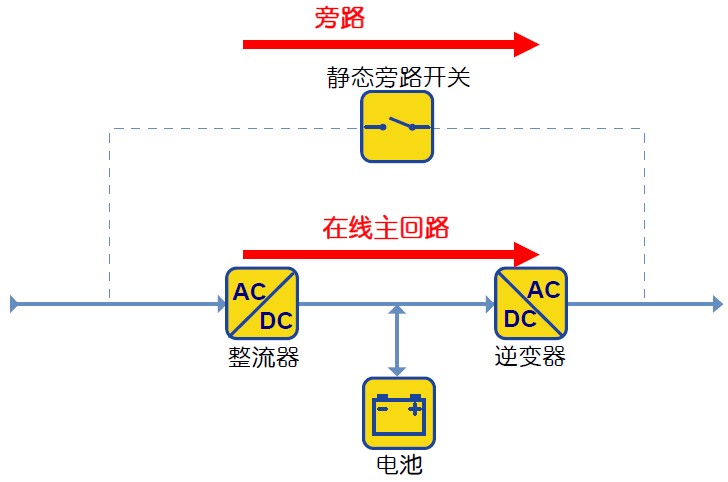

变频技术虽然在低负载的情况下有效提高能效,提升节能的效果,但是在单方面追求能效提高节能的情况下,忽视的变频带来新的问题:谐波危害,谐波带来:

u 谐波对电网的干扰

u 降低电力设备使用寿命

u 影响到IT设备的正常工作

因此目前电力部门要求在低压配电侧必须加装谐波治理减少对电网的干扰,IT、广电和通讯行业更是强制要求增加谐波治理的设备来解决信号传输中的干扰问题。

变频器是一个电子的设备,故障率高于定频机,增加后期的维护成本。还需要看到变频器和谐波治理设备有2%左右的耗能,因此当负载超过80%时,反而增加的能耗,未能起到节能的目的。

采用变频技术增加初期的投资,与大功率冷水机组相配套的变频器+谐波治理设备一套造价在40万左右。

因此:

1)变频技术虽然在一定的环境下能够调节系统运行状态,起到一定的节能效果,但是在80%以上(含)负载带来负面影响反而增加了能耗,没有达到节能的目的,同时增加了投资。

2)谐波对环境的影响,需要增加治理的设备。GB50174-2017 《数据中心设计规范》要求:向公用电网注入的谐波电流分量(方均根值)允许值应符合现行国家标准《电能质量公用电网谐波》GB/T14549的有关规定,因此在数据中心的建设中必须增加谐波治理。

4、风冷冷水机组与离心冷水机组比较

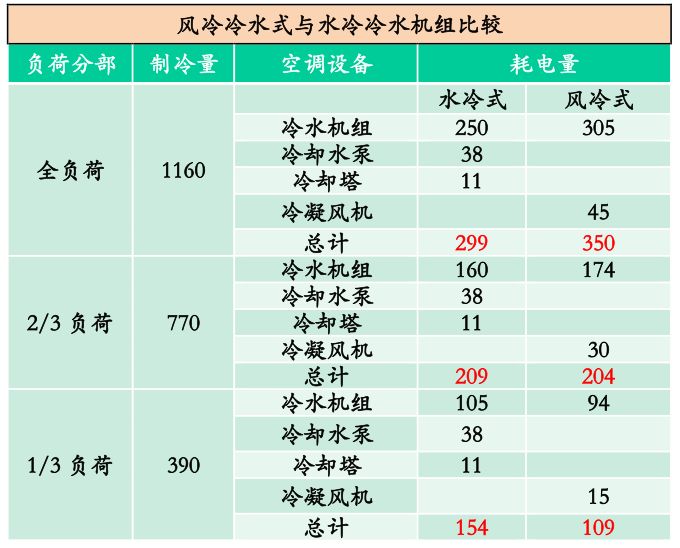

目前数据中心的水冷空调有风冷冷水和水冷冷水机组,特灵公司做过离心水冷冷水机组与风冷冷水机组在全负荷、部分负荷的耗电量比较,其结果见表5。

表5风冷冷水式与水冷冷水机组比较

全负荷时风冷机组耗能大于水机组,大约为15%

2/3负荷时两者基本持平

1/3负荷时风冷机组耗能低于水冷机组,大约为30%

可见风冷水冷与水冷冷水机能耗差别不大,水冷冷水机组在用水量,冷塔、水处理、冷凝器以及管道的清洗等维护保养的费用高于风冷冷水机组,如果加上自然冷却,其风冷冷水优势会大于水冷冷水系统。

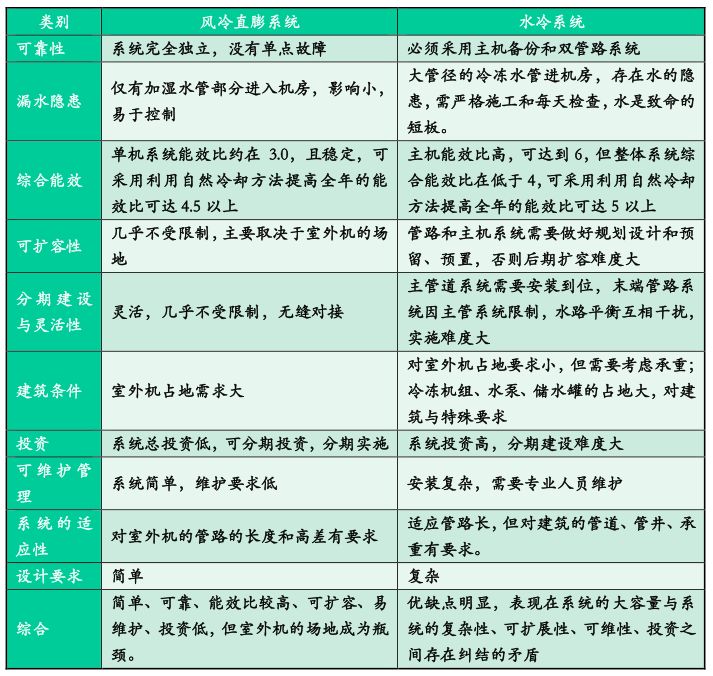

5、风冷直膨与水冷系统的综合比较

目前数据中心主流的空调系统有风冷直膨精密空调与水冷空调,表6给出这两种空调系统综合比较关系。

表6 风冷直膨与水冷系统的综合比较

如何选择,需要根据环境、规模、系统复杂性、可维性等角度综合平衡,科学的选择适合的空调系统。

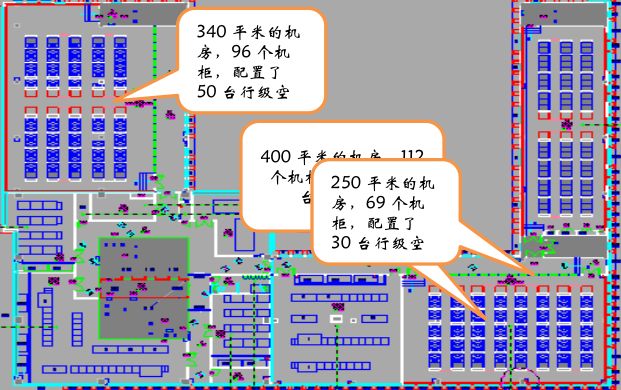

6、行级制冷空调并不节能

行级制冷空调最早是用来解决对大于8KW高密度机柜的精确制冷。随着模块化数据中心和微模块机柜组合的出现,工厂订制化生产和快速部署的优势,给行级空调赋予了新的使用范围。但是在现实的数据中心的建设中,将行级空调作为标准设计,采用行级空调作为常规空调系统应用,会带来以下的问题:

1)全部采用行级制冷空调总的制冷量需要增加20%;

2)行级制冷的空调增加30%的投资;

3)全部采用行级空调需要与冷通道封闭配套,否则当一台行间空调故障时,会直接影响到左右相邻机架的制冷;

4)采用水冷的行级制冷空调,水路复杂、水进机房,跑冒滴漏带来很大的安全隐患。

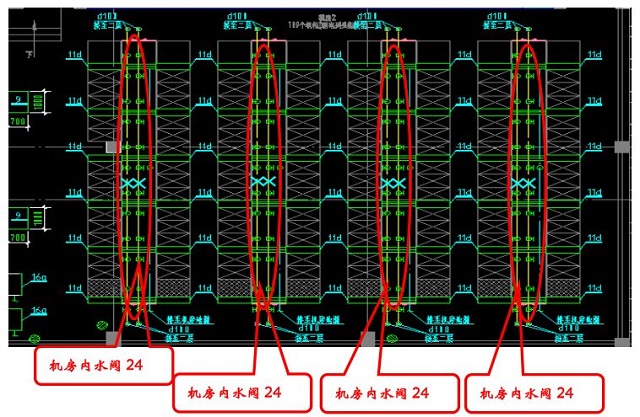

图5和图6给出某个数据中心行级空调的案例,277个机柜用了128台行级空调,差不多两个机柜配一台行级空调。在一个112个机柜的机房中,48台行级空调配置了96只控制水阀。

图5 某数据中心大量使用行级空调的实例

图6 48台行级空调使用了 96 个水阀

因此,在数据中心的建设中,行级空调不是一种节能的产品和标准化的设计,大面积的采用行级空调,增加投资、管道的复杂性、给后期运维带来风险和工作量,同时并不能起到节能的效果。

二、空调系统对数据中心建筑的要求

1、水冷系统对建筑的要求

在2010年以前,数据中心的制冷还是风冷直膨精密空调独统天下,2010年以后,水冷系统走进数据中心,已成为当下中大型数据中心流行的设计,其原因是数据中心的大型化以后传统的风冷直膨精密空调遇到难以解决的问题:一是风冷直膨精密空调存在室外机的距离和高差限制,二是大量的室外机受到室外安装场地的限制。但是风冷冷水机组、冷却塔一般安装在屋面,其重量在几吨至几十吨,需要对建筑的荷载、防水、避雷、抗震要做特殊处理,因此需要增加建筑的成本。

离心冷水机组、水泵、板换、集/分水器、水处理器、定压补水、蓄冷罐等设备需要占用有效的建筑空间,一个5000平米的数据中心,冷水机组等辅助设备需要1000平米的有效建筑面积,不仅增加相应的建筑成本,同样挤占了数据中心机房的面积。

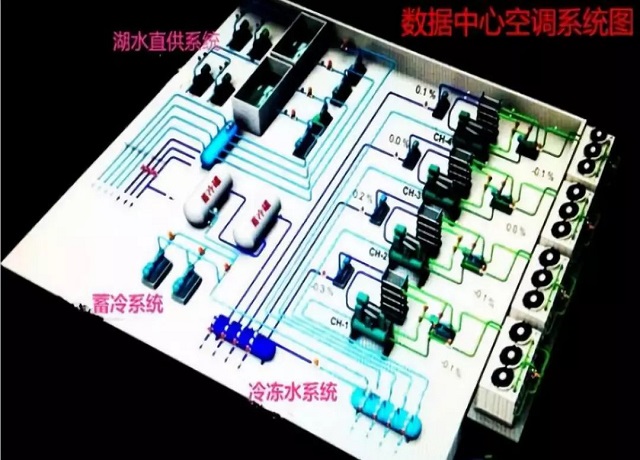

地表水制冷已走进数据中心,为了防止水质、枯水期、水温不能满足要求,尽管只有1%的可能,需要建立双系统,双系统需要更多的占用数据中心的建筑面积(见图7)。

图7 湖水制冷需要双系统和占用更多的建筑面积

2、风墙技术对建筑的要求

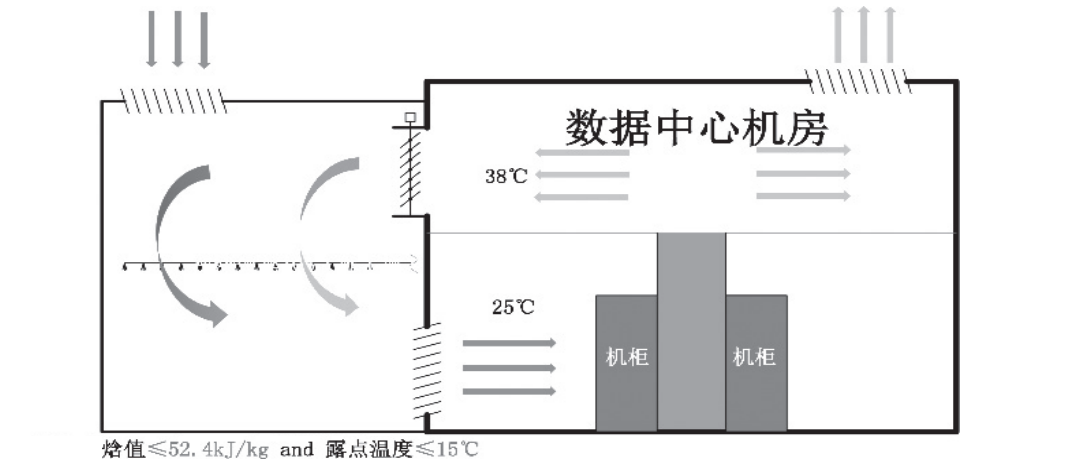

风墙技术已经在国内的多个数据中心得到应用,风墙技术中与外界自然环境的温度处理系统需要特殊的进风、混合和排风的建筑结构,同时占用较大的建筑面积,基本上其面积与IT机房的面积为1:1(见图8)。

图8 风墙技术的实际案例

在风沙、雾霾和雨雪天气制约了风墙的使用,因此需要增加一套水冷空调来做备份。这部分的水冷设备也需要占用一定的建筑面积,通俗的讲数据中心的得房率不高。另外增加的水系统需要考虑建筑的承重,必须做加固处理。

因此在节能的同时,还需要关注不同的空调系统系统会增加相应的建筑成本,同样增加了数据中心机房的面积占比,这是建设方需要综合考虑的问题。

三、水冷系统需要关注的其他问题

1、水源成为数据中心运行的短板

在水冷冷水空调系统中,将机房产生的热量通过水传导吸收机房的热量,再用另一路冷却水进行冷却降温后再回到冷水机组制冷,采用冷却塔降温,其蒸发的损耗是冷却塔流量的1%。一个1000个机架(单机架4KW)数据中心,满负荷运行时一天需要蒸发400吨冷却水,很少有两路供水的的数据中心(水不同于电,电可以自备发电机),当市政供水管网故障时(如水管爆裂或检修),一般修复的时间很长,数据中心会因断水而停机,在某数据中心就发生过用洒水车拉水救急的案例。

因此水成为数据中心运行的短板,在建设中额外需要增加数百吨的冷却水的补水池或增加其他的应急制冷系统。图9为某数据中心为了防止水的短板带来的安全风险,采用水冷冷冻水和风冷冷冻水两套完全独立的水系统。

图9 某中心防止停水

设置水冷冷水系统和风冷冷水两套系统

2、离心水冷冷水机组的喘振问题

选用离心冷冻机组,如果负载低于20%会出现喘振,导致系统宕机,目前解决低负载的喘振的办法有两种:一是利用蓄冷罐作为过渡,水冷主机先对冷冻水进行遇冷,当达到设置温度是停冷水主机,由蓄冷罐的冷冻水给机房制冷,此方案给运行的控制带来一定的难度。二是在初期负载很低的情况下使用假负载来保证空调系统的运转(有此案例),使用假负载不仅没有达到节能的目的,反而增加的能耗。

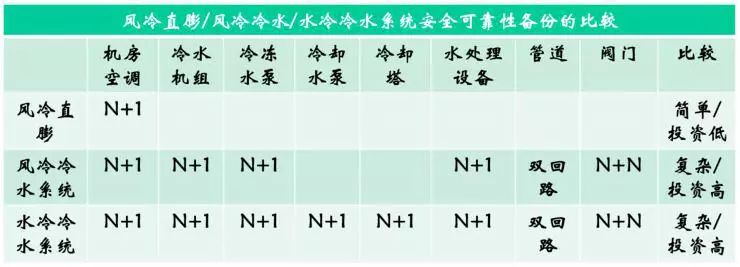

3、需要关注系统备份与冗余的复杂性

水冷系统架构非常复杂,需要配套的设备、管道、阀门繁多。复杂的水处理系统不仅增加施工的难度和后期运维的难度,同时水进机房带来跑冒滴漏运行风险。

数据中心的空调系统建设中需要考虑到运行的可靠性和可维性,因此需要增加一部分的冗余备份,在出现故障或维护时可以满足不中断运行的在线维修,对不同的空调系统冗余备份的设备和数量是不一样的,系统的复杂性和投资也是不一样的,表7为不同空调系统冗余备份配置。

表7不同空调系统冗余备份的配置

可见系统配套的设备越多,系统越复杂,备份越复杂,增加投资越高。

四、需要关注运行的成本

1、初期运行对PUE制约

PUE是一个综合的指标,必须是在数据中心春夏秋冬四季运行的情况下综合测评。数据中心的投产的初期负载很少,要想PUE达到设计要求是不可能的,必须是在负载达到80%以上,这个需要几年的时间,才能显现出节能的效果,对企业的数据中心往往这个过程需要3年以上,甚至更长。

2、需要关注运维的成本

风冷直膨空调系统运行维护简单,日常只要做好巡检和室外机散热片定期冲洗外,没有故障不需要产生费用,不需要专业的技术人员。而采用水冷系统需要考虑以下的运行的成本:

1)一个1000个机柜(单机柜4KW)的数据中心,采用水冷冷水系统,冷却塔满载运行一天蒸发的耗水量需要400吨,这部分是需要折算到能耗中,也就说需要考虑WUE指标。

2)要考虑每年的维护保养的费用,对水的软化处理、每年管道的清洗、加药(除菌、除锈)、更换机油和过滤器、补充制冷剂等。

3)在北方,室外零下的温度需要给冷却塔、和管道电加热,否则水管冻裂直接导致机房的温度上升而宕机。一台1000RT的离心水冷机组所配套的冷却塔需配60kW的电加热器(由4个模块组成,每个模块15kW),管道的电伴热也需要消耗一定的电能。

4)水系统需要至少增加1~2个专业的工程师,还需要安排24小时值班,增加人力的成本。

以一个2000个机架数据中心采用水冷冷水系统为例,每年的增加的运行和维护费用超过200万,相当于空调系统需要节能200万的电费才能抵消。

3、需要综合平衡节能投资与数据中心生命周期的关系

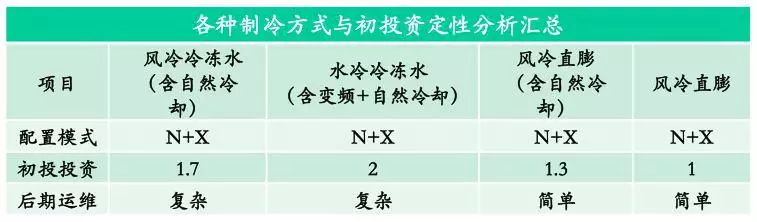

如果将PUE从2.0提升到1.5,需要增加基础建设的投资,特别是空调系统。即使不考虑这些系统每年运行费用,至少需要3年才能收回成本。但是实际情况是投产初期由于低负荷工作,加上每年的运维的费用,往往需要8年甚至更长,延长了回收成本的年限,表8给出不同制冷系统初投资的比较(设风冷直膨系统投资为1)。

表8 不同制冷方式与初投资比较

在建设中需要考虑数据中心运行生命周期,每个设备都要经历安装、运行、老化和更新的过程,每个设备的生命周期取决于设计寿命、运行环境、带载能力和技术的更新,当设备老化带来性能和可靠性的下降时,就需要及时淘汰和更新,因此过度的投资会带来投资回报率的下降。下面给出数据中心的生命周期表图(见表9)。

表9 数据中心基础设施的生命周期

五、地表水和风墙制冷需要关注的其他问题

近几年利用地表水直接制冷和利用自然环境的低温制冷走进数据中心的空调系统,节能效果显著,然而有下列的问题需要给予足够的关注:

1、地表水制冷对环境的要求

充分利用地表水(江河湖水)自然冷却,可以大幅度提升PUE,CLF可以达到1.1,还需要关注以下的问题:

1)利用江河湖水作为冷源,应对水体资源和水体环境进行评价,并取得相关部门的批准同意。当江河湖为航运通道时,取水口和排水口的设置位置还应取得航运主管部门的批准。

2)利用江河湖水作为冷源,应考虑丰水、枯水季节的水位差,并应有措施防止洪水对数据中心造成影响。

3)水的净化处理和防绿藻;

4)数据中心产生的热水需要做降温处理,不能直接排放到湖里,否则破坏环境和生态。

5)冬季有冻结可能的地区,制冷系统应有防范措施。

2、风墙技术对环境的要求

充分利用室外自然的低温空气通过风墙对IT的设备进行冷却和换热。可大幅度提升PUE,除了需要特殊的建筑结构和较大的场地外,还需要关注以下的问题:

1)对空气质量要求高,不适合雨雪、风沙、灰霾天,机房主设备会被逐渐腐蚀,增加除尘和除有害物质(如二氧化硫等)建设和维护成本,考察过某个风墙数据中心的案例,一个400平米的机房,每年更换中效过滤器的成本需要40万,如果需要除硫等有害物质的费用更高,这部分维护成本将抵消节能带来好处。

2)系统复杂,投资高:为了解决全年10%的空气质量不达标的天气,需要再建一套蒸发制冷或水冷系统。

结束语

上面从六个方面分析了数据中心空调系统能效和节能需要关注的现实问题,这里需要说明的是不是否定上述的技能技术和产品,而是选择什么样的空调系统,如何将节能与运维、投资与PUE回报达到最佳平衡,需从规划、地理环境、气候、水资源、规模、建筑、投资、复杂程度、电力成本、维护成本、人力资源、系统的能效、设备的生命周期、稳定性和可维性等维度对各种空调系统做综合比较,通过评估后选择最佳组合方案。总之节能是一个贯穿数据中心生命周期的永恒的追求目标,量体裁衣,科学抉择,才能最终达到建设与运行总能耗的平衡。

最后谈一点写这篇文章的初衷、个人的体会:

随着数据中心建设规模、数量和电力不断增长,节能减排、绿色数据中心成为热门的话题和追求的目标,因此节能技术和产品百花齐放,在近几年行业会议、论坛都在宣传、介绍各种节能的技术和产品,以及节能的案例,都是一片赞歌,没有(或很少)涉及到节能背后存在的问题和困惑。

我在IT行业工作有近50年的时间,负责或参与大大小小的机房建设不下30个(大到4万平米,小到百十平米),这几年考察(或跟进)的大型数据中心也不下十个,与设计院、产品制造商、建设方、运维方做过大量的交流,对比过不同产品性能指标,每年也参加数个数据中心的方案评审,跟踪过一些数据中心运行状况。看到不少的数据中心的建设中和运维遇到很多的问题,有些未能达到设计指标、有些运维的成本很高、有些运行的故障很高,有很多的数据中心运行5年还没有收回投资,有些在行业中产生了误导(比如很多的单位数百平米机房指定水冷系统为首选,认为空调节能就是水冷空调,行间级的空调作为标配的设计)等等。

因此这几年收集、对比和实地核准,整理大量的数据,写成这篇文章,在数据中心工作组、中数盟、计算机协会等团体举办的论坛上做演讲。很多的产品厂商、设计院、建设和运营方都认同问题的存在,但是厂商和设计院都规避这些问题,结果是建设方和运营方被动的承担其后果。这里再次强调和说明的是,作为上述的节能技术和产品本身在提高能效和节能是没有问题的,问题是不能孤立的看其优点,更要看系统的效果和需要关注的问题,就像药品的性能说明书中一定是同时给出功效+副作用+注意事项。总之是希望从不同的角度来关注节能中问题。

本文标题:浅谈数据中心空调系统节能的若干问题

本文链接:https://www.blueocean-china.net/faq3/1116.html [版权声明]除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。